最近我们的一位读者问我们如何优化robots.txt文件才能提升SEO的效果。Robots.txt是用来告诉搜索引擎如何抓取你网站的内容,所以这也让它成为了一个令人没有想到的强大的SEO工具。在本文中,我们将向你展示如何针对SEO创建一个完美的robots.txt文件。

文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

什么是robots.txt文件?

Robots.txt是一个文本文件,网站主可以用它来告诉搜索引擎的爬虫如何抓取和索引网站的页面。通常这个文件位于网站根目录的文件夹内,robots.txt的基本格式如下所示:文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

User-agent: [user-agent 名字] Disallow: [禁止抓取的URL地址] User-agent: [user-agent 名字] Allow: [允许抓取的URL地址] Sitemap: [网站XML格式的站点地图URL]

你可以用多行指示去允许或禁止特定的URL以及添加多个站点地图。如果你没有禁止某个URL,那么搜索引擎爬虫就认为他们是可以抓取的。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

下面是一个robots.txt的例子:文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

在上面的例子中,我们允许爬虫去抓取及索引WordPress的uploads文件夹。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

接下来,我们禁止爬虫抓取plugins和wp-admin的文件夹。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

最后,我们提供了网站XML格式站点地图的URL地址。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

你的网站也需要Robots.txt文件吗?

如果你的网站没有robots.txt这个文件,搜索引擎仍然还是会去抓取并索引你的网站的。但是,你就没法告诉那些爬虫哪些页面或文件夹不应该抓取。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

这在你刚刚搭建博客还没多少内容时是没什么太大的影响的。但是随着网站的发展,当你的拥有了大量的内容时,你就会希望对如何抓取网站内容有更好的把控。文章源自飞鸟学习网-https://www.pk88.net/2023-0308-3.html

以下就是一些原因。

搜索引擎爬虫对每个网站都有一个抓取配额,这也就是说它们在一个抓取时间段内会抓取一定数量的页面。如果它们没有完成对你网站上所有页面的抓取,那么他们会在下次回来的时候继续抓取。这会降低你的网站索引速度。

你可以通过禁止爬虫抓取不必要的页面(像WordPress管理员页面,插件文件以及主题目录)来修复这个问题。通过禁止不必要的页面,你可以节省爬虫的配额,这样就可以让爬虫抓取更多的页面并尽快建立索引。

另一个使用robots.txt的理由是当你想让搜索引擎停止索引文章或页面时。虽然这并不是向公众隐藏内容最安全的方法,但它可以帮你阻止将它们显示在搜索结果中。

一个理想的Robots.txt文件应该长什么样?

很多流行的博客都在使用非常简单的robots.txt文件,它们的内容可能会有所不同,具体取决于特定网站的需求:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

这个robots.txt文件允许所有的爬虫去索引所有的内容并向它们提供网站XML网站地图的链接。

对于WordPress站点,我们推荐在robots.txt文件中遵循规则:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

上面的规则告诉爬虫去索引uploads文件夹内所有的WordPress图片和文件,禁止爬虫索引WordPress插件的相关文件、WordPress管理员目录、WordPress readme文件以及affiliate链接。

通过在robots.txt文件中添加网站地图,可以让Google的爬虫更轻松的找到你网站的所有页面。

好了,现在你已经知道了一个理想的robots.txt长什么样了,现在我们一起来看下如何在WordPress中创建robots.txt文件。

如何在WordPress中创建robots.txt?

有两种方法可以在WordPress中穿件robots.txt文件,你可以根据自身情况选择最适合的方法。

方法一:使用Yoast SEO去编辑robots.txt

如果你正在使用Yoast SEO插件,那么插件本身就自带了rebots.txt文件生成器。你可以在管理员后台通过Yoast SEO插件直接创建并编辑robots.txt。

在管理员后台页面点击左侧边栏的“SEO” – “工具”,然后点击“文件编辑器”链接。

在下个页面中,Yoast SEO会显示你已有的robots.txt文件,如果没有该文件的话,可以点击“创建robots.txt”按钮来生成一个。

默认生成的robots.txt文件会包含下面的几条规则:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

上面的规则告诉所有的爬虫,禁止抓取/wp-admin/路径下的所有文件,但admin-ajax.php除外。但是我们建议你按照上面给出的最完美的格式来编辑。

方法二:使用FTP手动编辑Robots.txt文件

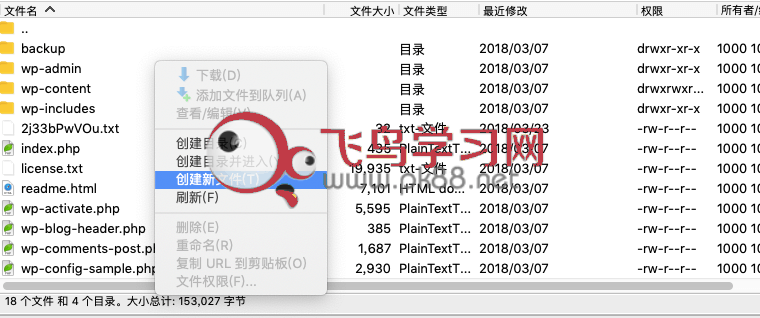

这个方法里,你需要用到FTP客户端去编辑robots.txt。先用FTP连接到网站服务器,然后在网站根目录中你可以看到robots.txt文件

如果根目录里没有看到robots.txt的话,那可能你的网站还没有这个文件,那么你可以直接在FTP中新建一个。

Robots.txt是纯文本文件,所以你可以直接将文件下载到电脑上用纯文本编辑器打开,例如Notepad或者TextEdit。

编辑完并保存后,将文件上传到网站根目录,覆盖原来的空文件。

如何测试robots.txt文件?

Robots.txt文件创建好以后,最好是用测试工具进行测试,网上有很多robots.txt测试工具,但是我们推荐使用Google Search Console里面的工具。

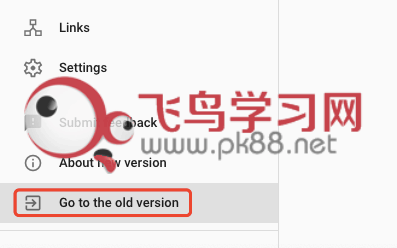

登录你的Google Search Console账户,然后切换到旧版界面。

在旧版页面,点击左侧边栏菜单中“Crawl”下面的“robots.txt tester”进入测试工具界面。

测试工具会自动获取网站的robots.txt文件,如果发现错误或警告的话会高亮显示。

一些总结

优化robots.txt文件的目的是为了阻止搜索引擎去抓取不对外公开的页面。例如,wp-plugins文件夹里的页面或者WordPress管理员目录里的页面。

在SEO专家中流传的一个误解是,屏蔽了WordPress的目录(category),标签(tags)和归档(archive)页面有助于提高抓取速度,能更快的收录页面,提高排名。

这是错误的,而且也违背了Google网站管理员指南。我们推荐你按照上面的robots.txt格式去创建robots.txt文件。

希望这篇文章能够让你真正了解并学会如何优化robots.txt文件。

全站资源源于网络整合,仅供学习研究,不可商用,不提供技术指导,如有侵权请告知删除,可以投稿,广告合作联系V: pk88net